在今年4月初开幕的图形处理器技术大会(The Nvidia GPU technology Conference, 简称GTC)上,NVIDIA展示了针对VR虚拟现实和深度学习应用的最新技术和产品。

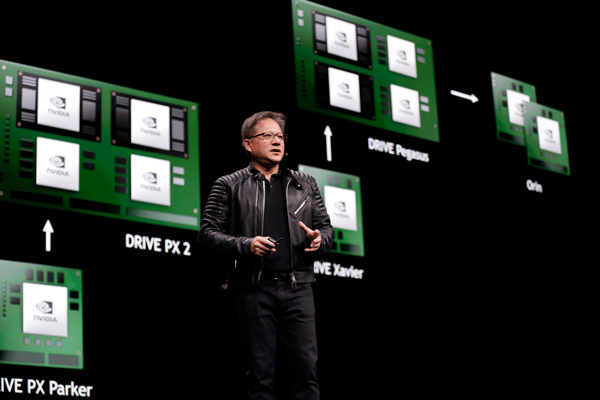

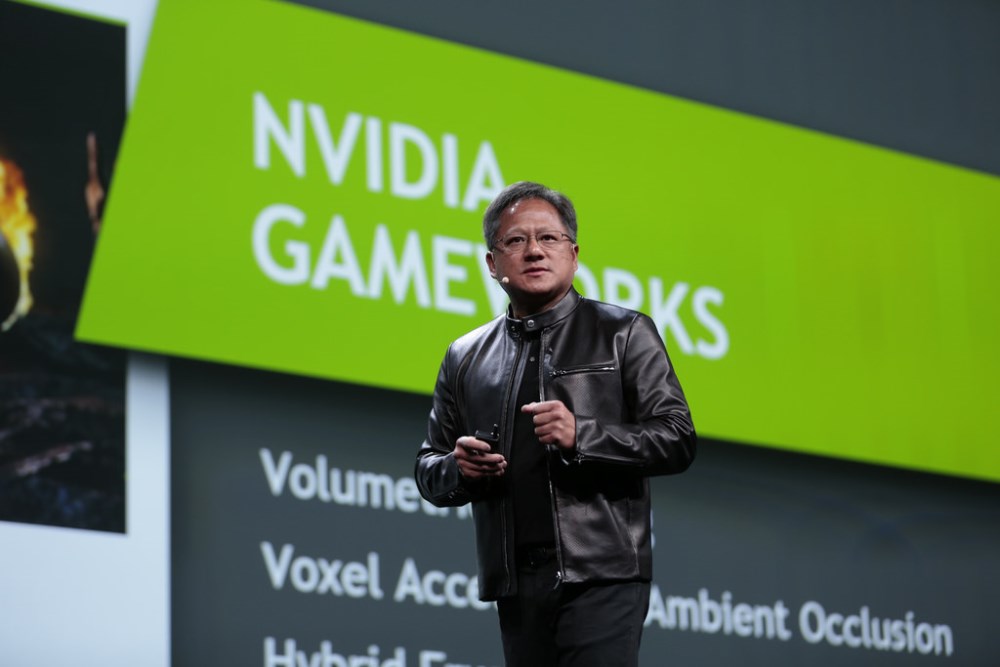

在开场的主题演讲中,NVIDIA联合创始人兼CEO黄仁勋在反复重申“一个全新的计算模型”这样的字眼。他指出,“消费市场需要的计算机可再也不是那种马马虎虎就能打发的一般产品。大家都愿意享受超级计算速率带来的快感,特别是基于GPU加速带来的计算体验”。

当然,超级计算时代的到来并非只是想想就能实现的,基于这样的目标,NVIDIA在今年的GTC大会上推出了包括GPU芯片Tesla P100(基于全新Pascal平台架构上打造)、DRIVE PX2(用于自动驾驶汽车的开发平台)和用于深度学习研究的超级计算机DGX-1(使用Tesla P100芯片建造,运算速度可达170万亿次)在内的一系列新技术和新产品。

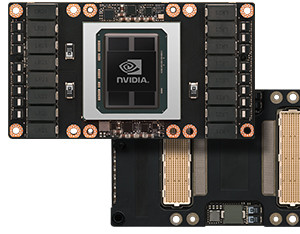

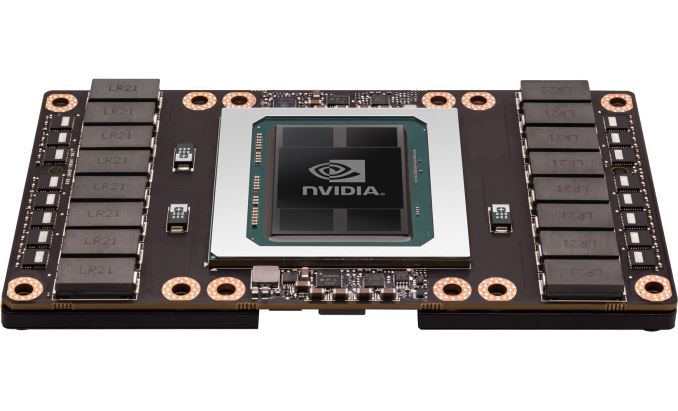

NVIDIA Tesla P100图形处理器芯片

NVIDIA Tesla P100图形处理器芯片

为深度学习应用搭建的全新解决方案

基于NVIDIA全新计算平台Pascal打造的Tesla P100 GPU芯片集成了NV Link总线,16GB HBM2显存,内建3584个CUDA,224个纹理单元,16GB HBM2显存,带宽可达到720GB/s,拥有基于16nm FinFET工艺打造的最大GPU核心。

NVIDIA Tesla P100图形处理器芯片

NVIDIA Tesla P100图形处理器芯片

此外,Tesla P100芯片也是继2014年发布,基于Kepler架构平台打造的Tesla K80之后,Tesla系列GPU产品的首次重大升级。

不过既然这是一款针对深度学习打造的GPU芯片,那么这里还必须要提一下Tesla P100芯片使用的NVIDIA旗舰GP100核心。GP100的性能一公布,给车云菌的感觉就是NVIDIA这次回归了GK110大核心时代注重双精度运算的设计,而且比之前更加变态。它每组SM单元中有64个FP32单元,但有32个FP64单元,FP64与FP32比例是1:2。这样的设计意味着GP100的FP32 CUDA核心可以同时执行2个FP16半精度运算,因此FP16浮点性能高达21.6TFLOPS。

NVIDIA GP100核心架构示意图

NVIDIA GP100核心架构示意图

GPU并行运算的特性很适合深度学习。据车云菌了解,NVIDIA在Tesla P100之外还推出了基于GP100核心的DGX-1深度学习超级计算机,由8颗GP100核心及2颗16核Xeon E5处理器组成,深度计算性能达到了170TFLOPS,号称比250台X86服务器还要强大。

NVIDIA 超级计算机DGX-1 售价高达$129000,真心不便宜

NVIDIA 超级计算机DGX-1 售价高达$129000,真心不便宜

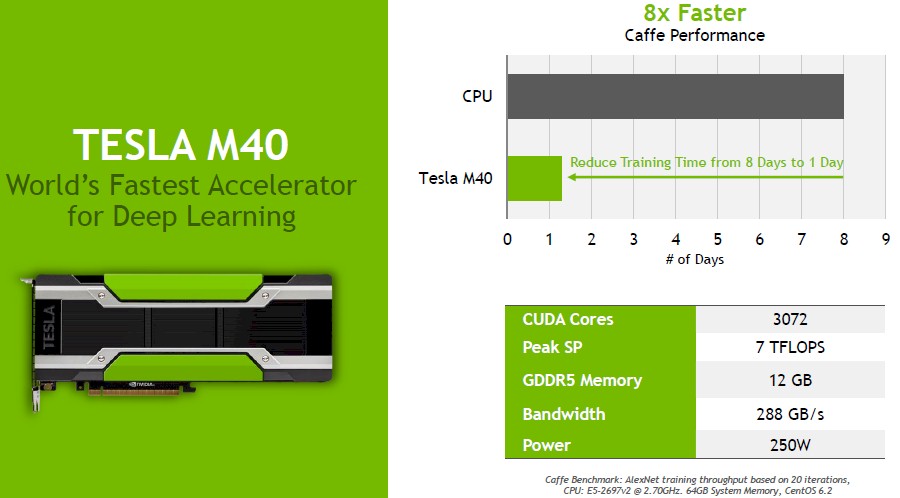

在过去的两年里,每次GTC大会的主题演讲环节,黄仁勋都会将话题的重点放在深度学习和神经网络研究上,并适时推出相关的新技术和新产品,而这些为NVIDIA之后进行人工智能的研究奠定了基础。今年也不例外。除了基于Pascal全新架构平台打造的Tesla P100芯片外,NVIDIA还发布了两款Maxwell计算平台下的全新GPU芯片—Tesla M40/M4,是为深度学习应用而特别打造的。

显而易见的是,使用通用的架构平台,相同的算法,这样便于进行高效的深度学习研究。而如果按照传统的解决办法,程序是不同的专家写的,不同的算法导致的实验结果可能也会千差万别。因此,要长期进行深度学习研究,NVIDIA的这两款芯片封装了固定的算法,并且提供了海量数据和强大的计算能力供你使用。

NVIDIA的Tesla M40芯片拥有8倍更快的caffe性能

NVIDIA的Tesla M40芯片拥有8倍更快的caffe性能

因此,如果只考虑深度学习训练,NVIDIA的Tesla M40/M4还是相对比较合适的(百度的深度学习研究院就用的这一款),相对于K40单精度浮点运算性能是4.29Tflops,M40可以达到7Tflops。

驱动自动驾驶汽车发展的深度学习

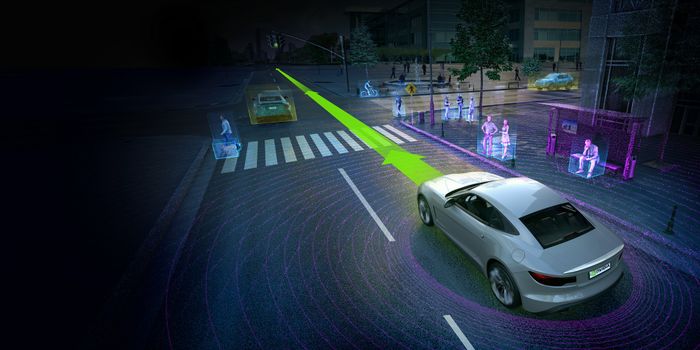

深度学习有成千上万种潜在的应用领域,在自动驾驶技术上的研究算得上是现下最热门的一个。尽管基于深度学习打造的自动驾驶汽车平台仍处于概念阶段,但NVIDIA一直都在同主机厂和软件开发商合作,设计开发不仅能够模仿人类驾驶员同时还可以在复杂情况下做决定的自动驾驶平台。

DRIVE PX 2是NVIDIA最新开发的用于自动驾驶汽车的硬件计算平台。相比之前把后备箱塞得满满当当的工控机,DRIVE PX 2在体积上已经大大缩小。

NVIDIA DRIVE PX 2自动驾驶开发平台

NVIDIA DRIVE PX 2自动驾驶开发平台

我们不妨先看看DRIVE PX 2的一些基本性能参数:

1.基于16nm FinFET工艺,功耗高达250W ,采用水冷散热设计。支持12路摄像头输入、激光定位、雷达和超声波传感器;

2. CPU部分:两颗新一代NVIDIA Tegra处理器,当中包括了8个A57核心和4个Denver核心;

3. 首发NVIDIA的新一代GPU架构Pascal(即帕斯卡,宣称性能是上一代的麦克斯韦构架的10倍),单精度计算能力达到8TFlops,超越TITAN X,有后者10倍以上的深度学习计算能力。

那么既然有了如此强大的性能,NVIDIA的DRIVE PX 2平台到底如何在自动驾驶汽车上发挥作用呢?这里要重点讲一下它在高精度地图绘制上发挥的优势。DRIVE PX 2能够将外部传感器获取的图像数据加工处理后制成单个的高精度点云。系统将所有DRIVE PX 2平台的点云数据上传至云端服务器,经过DGX-1处理后,可融合为一副完整的高精度地图。所以,车内的DRIVE PX 2,云端的DGX-1配合发挥作用,形成了NVIDIA完整的自动驾驶技术平台解决方案。

前面车云菌已经为大家简单介绍了DGX-1的架构和参数,那么它的性能到底有多强,我们通过下面这个例子就能直观地了解到。

将DGX-1和一枚因特尔的双核Xeon处理器作比较。这枚双核Xeon的运算速度为3 teraflop,但DGX-1的运算速度为170 teraflop。那么这意味着如果用这枚双核Xeon芯片来训练Alexnet网络结构模型的话,它需要150个小时,但DGX-1却只要两个小时就够了。

此外,车云菌还了解到,NVIDIA将为自动驾驶汽车,打造名为“NVIDIA DIGITS”的端到端深度学习训练平台。该平台依靠DRIVE PX 2进行部署,通过网络让每一辆车都构建自己的深度学习网络。在此基础之上要建立“NVIDIA DRIVENet”的深度神经网络。它包括3个卷积码层,3700万个神经元,而信息在整个网络流经一次,会产生400亿次操作。

参加今年首届Roborace大奖赛的无人驾驶赛车渲染图

参加今年首届Roborace大奖赛的无人驾驶赛车渲染图

而涉及到具体应用层面,黄仁勋在GTC大会的主题演讲环节还透露称,参加今年首届Roborace 的无人驾驶赛车,将使用英伟达的 DRIVE PX 2 作为计算平台。明年,Drive PX 2还将被沃尔沃用于在瑞典哥德堡的实地自主驾车实验中。

车云小结

我们不妨看看最近恩智浦、高通和NVIDIA这三大芯片供应商在汽车领域都有哪些动作:

这个月16号,恩智浦NXP推出了一款用于模块化量产自动驾驶汽车的计算平台BlueBox,它的主要功能是将之前彼此隔离的单个传感器节点和处理器进行功能上的结合。而随着Android Auto重大更新的发布,芯片供应商高通也宣布未来将联手谷歌开发搭载有安卓操作系统的内嵌式车载娱乐信息系统平台,使用高通专为车机系统打造的骁龙820A和602A高性能处理器。当然NVIDIA今年也推出了DRIVE PX 2, Tesla P100以及超级计算机DGX-1,则是在深度学习领域火力全开。

这么看来,尽管自动驾驶技术还没有发展到Level 3这个阶段,各大芯片厂商已经陆续亮剑,祭出了各自的杀手锏。但产品的出发点还有所不同,优势领域亦各有差异,但芯片之争,已经开始。最后要吐个槽,虽然主打GPU的NVIDIA确实在深度学习应用上有优势,但业界一直吐槽他家的产品真是太贵了,价格一点都不亲民。你怎么看呢?